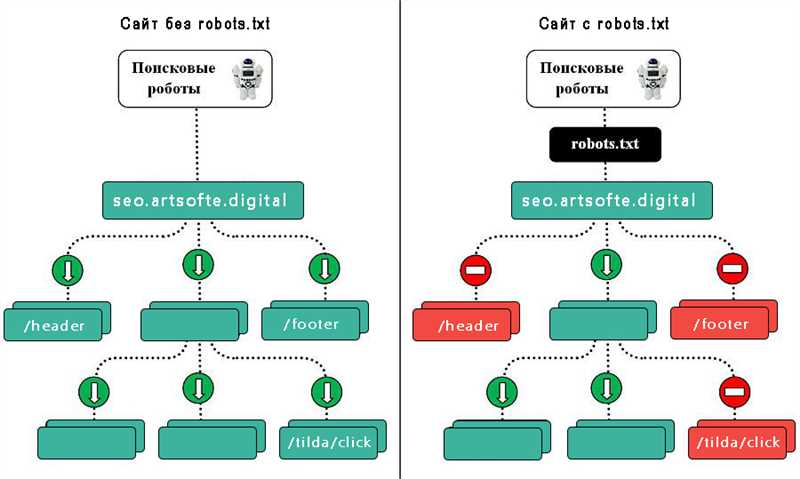

Robots.txt – это текстовый файл, который помогает веб-мастерам контролировать поведение поисковых роботов на своем сайте. Он располагается в корневой папке сайта и определяет, какие страницы сайта должны быть показаны поисковым роботам, а какие нет.

Индексный файл роботов – это основное средство коммуникации между веб-мастерами и поисковыми системами. Он позволяет определить, какие страницы сайта следует индексировать, какие страницы следует исключить из индекса и как часто роботы могут обращаться к сайту.

Правильное использование robots.txt помогает улучшить SEO-оптимизацию сайта. Он может использоваться для ограничения доступа к конфиденциальным или временным страницам сайта, а также для управления индексацией дубликатов страниц и блокировки плохих ботов. Кроме того, правильное использование этого файла помогает обеспечить более эффективную индексацию в поисковых системах и улучшить видимость сайта в результатах поиска.

Что такое robots.txt и зачем он нужен?

Основной целью использования robots.txt является предоставление инструкций для поисковых систем. Файл позволяет указывать, какие страницы сайта могут быть индексированы, а какие — нет. Это удобно, например, когда нужно скрыть некоторые вспомогательные или приватные страницы от поисковых систем. Также, robots.txt позволяет управлять скоростью индексации, указывать папки, которые должны быть исключены из индексации, и многое другое.

Пример использования файла robots.txt:

- Запретить индексацию всего сайта для всех поисковых систем:

- Разрешить индексацию всего сайта для всех поисковых систем:

- Запретить индексацию конкретной папки для всех поисковых систем:

- Разрешить индексацию конкретной папки только для определенной поисковой системы:

User-agent: * Disallow: /

User-agent: * Disallow:

User-agent: * Disallow: /private-folder/

User-agent: Googlebot Disallow: User-agent: * Disallow: /

Значение robots.txt для поисковых систем

Задача robots.txt состоит в том, чтобы уведомить поисковые системы о том, какие страницы сайта имеют общедоступный доступ, чтобы они не тратили свои ресурсы на индексацию дублирующего контента и нежелательных страниц. Также файл может использоваться для скрытия конфиденциальной информации, например, личного кабинета или административной части сайта.

Преимущества использования robots.txt:

- Управление индексацией: С помощью robots.txt можно ограничить или запретить доступ поисковым роботам к определенным разделам или файлам сайта. Это особенно полезно, когда нужно скрыть страницы с дублирующим или нежелательным контентом, чтобы не попасть под фильтры поисковых систем.

- Экономия ресурсов: Благодаря использованию robots.txt можно снизить нагрузку на сервер и уменьшить время, затрачиваемое поисковыми роботами на индексацию сайта, они не будут обрабатывать запрещенные разделы.

- Защита конфиденциальных данных: Robots.txt позволяет скрыть конфиденциальные разделы сайта от индексации поисковыми системами, что является важным для сохранения безопасности и защиты личной информации пользователей.

Как создать robots.txt:

Для создания файла robots.txt необходимо использовать текстовый редактор и сохранить его в корневой папке сайта. Файл должен иметь название «robots.txt» и быть доступным по адресу http://example.com/robots.txt, где «example.com» — доменное имя сайта.

| Пример robots.txt: |

|---|

|

В приведенном примере файл robots.txt получает следующие инструкции:

- User-agent: * — эта строка указывает на то, что правила в файле применяются ко всем поисковым роботам.

- Disallow: /admin/ — запрет индексации всех страниц в подкаталоге «admin».

- Allow: /public/ — разрешение на индексацию всех страниц в подкаталоге «public».

- Disallow: /private/ — запрет индексации всех страниц в подкаталоге «private».

- Disallow: /cgi-bin/ — запрет индексации всех страниц в подкаталоге «cgi-bin».

После создания и размещения на сервере файла robots.txt, поисковые роботы будут применять его правила во время индексации сайта.

Как использовать robots.txt на своем сайте

Чтобы использовать robots.txt на своем сайте, следуйте следующим шагам:

-

Разместите файл в корневой директории сайта.

Ваш файл robots.txt должен быть размещен в корневой директории вашего сайта. Например, если ваш сайт находится по адресу www.example.com, то ваш файл robots.txt должен быть доступен по адресу www.example.com/robots.txt. Если ваш сайт находится в поддиректории, то файл robots.txt должен быть размещен именно в этой поддиректории.

-

Определите правила доступа для поисковых роботов.

В файле robots.txt вы можете указать различные правила доступа для поисковых роботов. Например, вы можете запретить всем роботам доступ к определенным страницам или директориям, указав соответствующие директивы Disallow. Также вы можете разрешить доступ к определенным файлам или директориям для конкретных роботов с помощью директивы Allow. Указывая правила доступа, необходимо использовать относительные пути относительно корневой директории сайта.

Примеры правил доступа:

Директива Описание Пример Disallow Запрещает роботам доступ к указанным страницам или директориям сайта. Disallow: /private/ Allow Разрешает доступ к указанным страницам или директориям сайта для конкретных роботов. Allow: /images/ User-agent Определяет, для какого робота заданы правила. User-agent: Googlebot -

Проверьте правильность синтаксиса файла.

Файл robots.txt должен быть написан с соблюдением определенного синтаксиса. Проверьте правильность написания всех директив и правил, чтобы избежать ошибок. Ошибочно указанные правила могут привести к неправильному индексированию вашего сайта поисковыми системами.

Правильное использование файла robots.txt позволяет более гибко управлять доступом поисковых роботов к вашему сайту и его контенту. Важно следовать указанным выше шагам, чтобы обеспечить правильное функционирование вашего файла robots.txt и достижение желаемых результатов в отношении индексирования и сканирования вашего сайта.